生成AI(人工知能)で声を複製する「ボイスクローニング」を悪用した詐欺に遭遇したことがあるかどうか、米セキュリティーソフト大手マカフィーが日本など7カ国を対象に調査し、計727人が「自身が遭遇した」と回答したことが24日、分かった。日本は最少の30人で、「知人が遭遇」の人も含め100万円以上の金銭被害に遭ったとする人も。生成AIによる偽音声は岸田文雄首相の偽動画や米大統領選などでも問題となっており、対策が急務だ。

同社によると、調査は昨年4月に日本や米国、英国、ドイツ、フランス、インド、オーストラリアの18歳以上の計7054人を対象にオンラインで実施。自身や知人が詐欺に遭遇したことがあるかなどを尋ねた。

その結果「自身が遭遇」は計727人で、このうちインド202人、米国141人と続き、日本30人が最少だった。「知人が遭遇」は計1069人で、インド273人、米国182人で、日本の50人が最も少なかった。

日本の延べ計80人中51人が金銭被害に遭ったとし、最大で1万1~1万5千ドル(日銀によると、調査の昨年4月平均為替レートで約133万~約199万円)の被害を受けたと答えた人もいた。

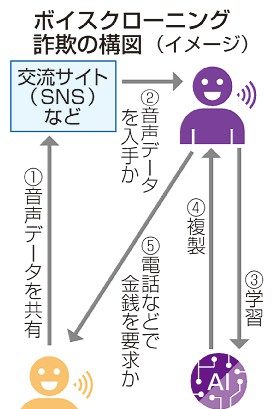

同社は、SNSなどインターネット上で共有された音声データでボイスクローニングが行われていると分析。親族らと似た声による電話やボイスメッセージで金銭を要求されたという声が複数寄せられたと明かした。

音声データを週1回以上共有しているのは半数超の計3730人で、インドが869人と最も多く、日本の281人が最少。同社は共有を慎重にし、家族や友人と合言葉を決めるなどの対策を取るべきだとしている。

ボイスクローニング 声の特徴を生成AI(人工知能)に学習させて声の「クローン」を作る技術。専門家によると、本物そっくりに偽のコンテンツを作る「ディープフェイク」の一種とされる。学習元の人に似た声色でテキストを読み上げる「音声合成」と、別の人の話し声を学習元の人の声に変換する「声質変換」の2種類がある。

有料

AI偽音声 悪用か 詐欺・金銭被害も、対策急務

ボイスクローニング詐欺の構図(イメージ)

ボイスクローニング詐欺の構図(イメージ)

この記事を書いた人

琉球新報朝刊

琉球新報朝刊